Redes de computadoras.

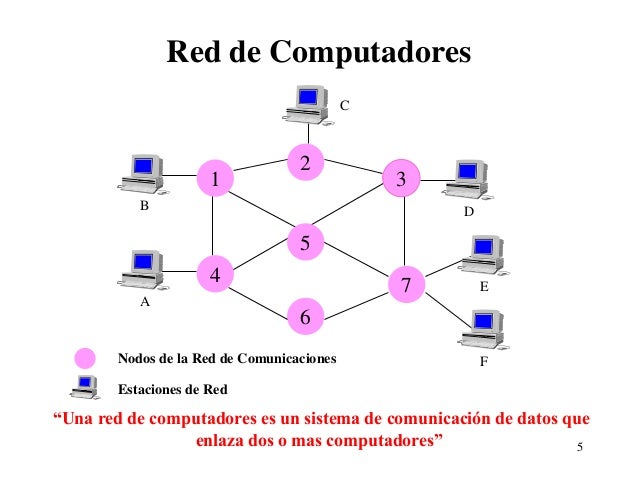

En esencia, una red es un conjunto de equipos informáticos interconectados entre sí. En toda red, hay una parte física y otra parte lógica. La parte física, está compuesta por todos los elementos materiales (hardware), y los medios de transmisión. La parte lógica (software), son los programas que gobiernan o controlan esa transmisión y la información o datos que es transmitida.

De este modo, una red de ordenadores puede ser entendida desde dos vertientes distintas:

• Conjunto de equipos interconectados con el fin de compartir recursos y transmitir información.

• Sistema de comunicación de datos entre equipos distintos.

Objetivos de las redes:

- Compartir recursos, equipos, información y programas que se encuentran localmente o dispersos geográficamente.

- Brindar confiabilidad a la información, disponiendo de alternativas de almacenamiento.

- Obtener una buena relación costo / beneficio.

- Transmitir información entre usuarios distantes de la manera más rápida y eficiente posible

Ventajas de una red de computadoras:

*Permite compartir el hardware

*Permite compartir programas y datos

*Permite que se pueda trabajar en grupo o colaborativamente

*Compartir archivos y recursos informáticos como el almacenamiento impresoras etc.

* Compartir Internet

*Comunicación de todo tipo entre las computadoras

*Crear un red de computadora es muy barato

*Comunicación rápida y eficiente

Desventajas de una red de computadoras:

*La privacidad de la información

*La seguridad de la información

*La instalación de la información

*La instalación puede ser costosa

*Todavía sigue siendo un poco complicada crear la red

*El desarrollo de las redes de la computadora es costoso

*La inseguridad en las redes

*Las computadoras deben poseer una gran capacidad de memoria si se requiere acceso rápido

Elementos de una Red de computadora.

Medios guiados.

Cable coaxial.

Un cable coaxial consta de un núcleo de hilo de cobre rodeado por un aislante, un apantallamiento de metal trenzado y una cubierta externa. El termino apantallamiento hace referencia al trenzado o malla de metal que rodea algunos tipos de cable. El apantallamiento protege los datos transmitidos absorbiendo las señales electrónicas espurreas, llamadas ruido, de forma que no pasan por el cable y no distorsionan los datos. Al cable que contiene una lamina aislante y una capa de apantallamiento de metal trenzado se le denomina cable apantallado doble. Para entornos que están sometidos a grandes interferencias, se encuentra disponible un apantallamiento cuádruple. Este apantallamiento consta de dos láminas aislantes y 2 capas de apantallamiento de metal trenzado.

Cable fino (THINNET):

Cable grueso (THICKNET):

Cables de par trenzado.

A menudo se agrupan una serie de hilos de par trenzado y se encierran en un revestimiento protector para formar un cable. El trenzado elimina el ruido eléctrico de los pares adyacentes y de otras fuentes como motores, redes y transformadores.

Tipos de par trenzado:

- Cable de par trenzado

sin apantallar (UTP): Con la especificación 10baset, es el tipo mas conocido de cable par trenzado y ha sido el cableado LAN mas utilizado. El segmento máximo de longitud de cable es de 100 metros. Consta de 2 hilos de cobre aislados las especificaciones dictan el numero de entrelazados permitidos por pie de cable; el numero de entrelazados depende del objetivo con el que se instale el cable.

- Cable de par trenzado apantallado (STP): Utiliza una envoltura con cobre trenzado, más protectora de mayor calidad que la usada en el cable utp. Stp también utiliza una lámina rodeando cada uno de los pares de hilos, ofrece un excelente apantallamiento en los stp para proteger los datos transmitidos de intermodulaciones exteriores, lo permite soportar mayores tasas de transmisión que los utp a distancias mayores.

Cable de fibra óptica.

Las señales que se transportan son señales digitales de datos en forma de pulsos modulados de luz. Es apropiado para transmitir datos a velocidades muy altas y con grandes capacidades. Consta de un cilindro de vidrio externamente delgado, denominado núcleo, recubierto por una capa de vidrio concéntrica llamada revestimiento a veces son de plástico.

Medios no guiados.

Red por radio: Es aquella que emplea la radiofrecuencia como medio de unión de las diversas estaciones de la red.

Red por infrarrojos (Infrared Data Association, IrDA): Permiten la comunicación entre dos nodos, usando una serie de ledes infrarrojos para ello. Se trata de emisores/receptores de ondas infrarrojas entre ambos dispositivos, cada dispositivo necesita al otro para realizar la comunicación por ello es escasa su utilización a gran escala. No disponen de gran alcance y necesitan de visibilidad entre los dispositivos.

Red por microondas: Es un tipo de red inalámbrica que utiliza microondas como medio de transmisión. Los protocolos más frecuentes son: el IEEE 802.11b y transmite a 2,4 GHz, alcanzando velocidades de 11 Mbps (Megabits por segundo); el rango de 5,4 a 5,7 GHz para el protocolo IEEE 802.11a; el IEEE 802.11n que permite velocidades de hasta 600 Mbps; etc.

Servidor: Es el elemento principal de procesamiento, contiene el sistema operativo de red y se encarga de administrar todos los procesos dentro de ella, controla también el acceso a los recursos comunes como son las impresoras y las unidades de almacenamiento.

Estaciones de trabajo: En ocasiones llamadas nodos, pueden ser computadoras personales o cualquier terminal conectada a la red. Se trabaja con sus propios programas o aprovecha las aplicaciones existentes en el servidor.

Sistema operativo de red: Es el programa que permite el control de la red y reside en el servidor.

Protocolos de comunicación: son un conjunto de normas que regulan la transmisión y recepción de datos dentro de una red.

Tarjeta de interface de red: Proporciona la conectividad de la terminal o usuario de la red física, ya que maneja los protocolos de comunicación de cada topología específica.

Cableado: Es el cable que se va a ocupar en la red que es físico se llama utp.

HUB o concentrador: En comunicaciones, centro de distribución, concentrador. Un Hub es un equipo de redes que permite conectar entre si otros equipos o dispositivos retransmitiendo los paquetes de datos desde cualquiera de ellos hacia todos. Han dejado de utilizarse por la gran cantidad de colisiones y trafico de red que producen.

Switchs o conmutador: Es un dispositivo digital de lógica de interconexión de redes de computadores que opera en la capa 2 (nivel de enlace de datos) del modelo OSI: su función es interconectar 2 o mas segmentos de red, de manera similar a los puentes (bridges), pasando datos de un segmento a otro de acuerdo con la dirección Mac de distinto de las tramas en la red.

Los conmutadores se utilizan cuando se desea conectar múltiples redes, fusionándolas en una. Al igual que los puentes, dado que funcionan como filtro en la red, mejoran el rendimiento y la seguridad de las lans.

Repetidor: Es un dispositivo electrónico que recibe una señal débil o de bajo nivel y la retransmite a una potencia o nivel más alto, de tal modo que se puedan cubrir distancias mas largas sin degradación o con una degradación tolerable. El término repetidor se creo con la telegrafía y se refería a un dispositivo electromecánico utilizado para regenerar las señales telegráficas. El uso del término ha continuado en telefonía y transmisión de datos.

Puente o bridge: Es un dispositivo de interconexión de redes de ordenadores que opera en la capa 2 (nivel de enlace de datos) del modelo OSI. Este interconecta 2 segmentos de red haciendo el pasaje de datos de una red hacia otra, con base en la dirección física de destino de cada empaque. Un bridge conecta 2 segmentos de red como una sola red usando el mismo protocolo de establecimiento de red. Funciona a través de una tabla de direcciones Mac detectadas en cada segmento a que esta conectado. Cuando detecta que un nodo de uno de los segmentos esta intentando trasmitir datos a un nodo del otro, el bridge copia la trama para la otra subred. Por utilizar este mecanismo de aprendizaje automático, los bridges no necesitan configuración manual.

La principal diferencia entre un bridge y un hub es que el segundo pasa cualquier trama con cualquier destino para todos los otros nodos conectados, en cambio el primero solo pasa las tramas pertenecientes a cada segmento. Esta característica mejora el rendimiento de la redes al disminuir el trafico inútil.

Ruteador: Es un dispositivo de propósito general diseñada para segmentar la red, con la idea de limitar trafico de brodcast y proporcionar seguridad, control y redundancia entre dominios individuales de brodcast, también puede dar servicio de firewall y un acceso económico a una WAN. Opera en la capa 3 del modelo OSI y tiene mas facilidades de software que un switch. Al funcionar en una capa mayor que la del switch, el ruteador distingue entre los diferentes protocolos de red, tales como ip, ipx, apple talk o decnet. Esto le permite hacer una decisión mas inteligente que al switch, al momento de reenviar paquetes.

GATEWAY (Puerta de enlace): es un dispositivo con frecuencia un ordenador, que permite interconectar redes con protocolos y arquitecturas diferentes a todos los niveles de comunicación. Su propósito es traducir la información del protocolo utilizado en una red al protocolo usado en la red del destino.

La dirección ip de un Gateway (o purta de enlace) a menudo se parece a 192.168.1.1 o 192.168.0.1 y utiliza algunos rangos predefinidos, 127 x.x.x, 10 x.x.x, 172 x.x.x, 192 x.x.x, que engloban o se reservan a las redes locales, ademas se debe notar que necesariamente un equipo que cumpla el rol de puerta de enlace en una red, debe tener 2 tarjetas de red.

MODEM: es un dispositivo que sirve para modular y desmodular una señal llamada portadora mediante otra señal de entrada llamada moduladora. La señal moduladora constituye la información que se prepara para una transmisión (un modem prepara la información para ser transmitida, pero no realiza la transmisión). La moduladora modifica alguna característica de la potadora de manera que se obtiene una señal, que incluye la información de la moduladora. Así el demodulador puede recuperar la señal moduladora puede recuperar la señal moduladora original, quitando la portadora. Las características que se pueden modificar de la señal portadora son:

Software:

Sistema operativo de red: Permite la interconexión de ordenadores para acceder a los servicios y recursos. Al igual que un equipo no puede trabajar sin un sistema operativo, una red de equipos no puede funcionar sin un sistema operativo de red. En muchos casos el sistema operativo de red es parte del sistema operativo de los servidores y de los clientes.

Software de aplicación: En última instancia, todos los elementos se utilizan para que el usuario de cada estación, pueda utilizar sus programas y archivos específicos. Este software puede ser tan amplio como se necesite ya que puede incluir procesadores de texto, paquetes integrados, sistemas administrativos de contabilidad y áreas afines, sistemas especializados, correos electrónicos, etc. El software adecuado en el sistema operativo de red elegido y con los protocolos necesarios permiten crear servidores para aquellos servicios que se necesiten.

Nodo: En informática y en las Redes de ordenadores o computadoras de área local, es un dispositivo que se encuentra conectado a las Conexiones de red con la capacidad de poder comunicarse con los diferentes dispositivos que se encuentren en la misma, las estructuras de árbol que son utilizadas en las bases de datos y en la programación que esta orientada a objetos, hace referencia este término a una ubicación que viene a ser el conjunto de una información del árbol, donde podría tener diferentes enlaces hacia uno o más nodos.

Clasificación de las redes de computadoras:

LAN (Red de Área Local, Local Area Networks):Las redes de área local suelen ser una red limitada la conexión de equipos dentro de un único edificio, oficina o campus, la mayoría son de propiedad privada.

MAN (Red de Área Metropolitana, Metropolitan Area Networks): Las redes de áreas metropolitanas están diseñadas para la conexión de equipos a lo largo de una ciudad entera. Una red MAN puede ser una única red que interconecte varias redes de área local LAN’s resultando en una red mayor. Por ello, una MAN puede ser propiedad exclusivamente de una misma compañía privada, o puede ser una red de servicio público que conecte redes públicas y privadas.

WAN (Redes de Área Amplia, Wide Area Networks): Las redes de área extensa son aquellas que proporcionen un medio de transmisión a lo largo de grandes extensiones geográficas (regional, nacional e incluso internacional). Una red WAN generalmente utiliza redes de servicio público y redes privadas y que pueden extenderse alrededor del globo.

PAN (Personal Area Networks, Redes de Área Personal): Las redes PAN son de alcance muy limitado (unos pocos metros), y se utilizan para interconectar dispositivos personales de manera inalámbrica (PCs, laptops, celulares, PDAs, impresoras, etc.) Estas redes son de velocidad media (algunos Mb/s) y están teniendo creciente desarrollo en los últimos años.

Red de área de almacenamiento (Storage Area Network, SAN): Es una red concebida para conectar servidores, matrices (arrays) de discos y librerías de soporte, permitiendo el tránsito de datos sin afectar a las redes por las que acceden los usuarios.

Red de área de campus (Campus Area Network, CAN): Es una red de ordenadores de alta velocidad que conecta redes de área local a través de un área geográfica limitada, como un campus universitario, una base militar, hospital, etc. Tampoco utiliza medios públicos para la interconexión.

Topología: O forma lógica de una red se define como la forma de tender el cable a estaciones de trabajo individuales; por muros, suelos y techos del edificio. Existe un número de factores a considerar para determinar cual topología es la más apropiada para una situación dada. La topología en una redes la configuración adoptada por las estaciones de trabajo para conectarse entre si.

Topología BUS

Red cuya topología se caracteriza por tener un único canal de comunicaciones llamado bus troncal o backbone se conecta en los diferentes dispositivos o demás nodos.

Ventajas:

Facilidad de implementación

Crecimiento y simplicidad de arquitectura

Desventajas:

Longitudes de canal limitadas

Un problema en el canal usualmente degrada la red

Topología de anillo doble

Consta de dos anillos concéntricos donde cada red esta conectada aun o mas anillos aunque los dos anillos no estén conectados entre si.

VENTAJAS:

Simplicidad de arquitectura

Facilidad de implementación y crecimiento

DESVENTAJAS:

El canal usualmente degrada la red

Topologia de árbol.

Es un cable de ramificaciones y el flujo de información jerárquicas.

VENTAJAS:

El cableado es de punto a punto para segmentos individuales

Soporte de multitud de vendedores de software y hardware

DESVENTAJAS:

La medida de cada segmento viene determinada por el tipo de cable si se viene abajo el segmento toda falla

Topologia de anillo.

Se compone de un solo anillo

VENTAJAS:

Simplicidad de arquitectura

Facilidad de implementación

DESVENTAJAS:

El canal usualmente degrada la red

Topologia de estrella.

Es la forma física en que todas las estaciones eran conectadas a un solo nodo central.

VENTAJAS:

Permite la comunicación de los demás nodos, presenta medios para prevenir problemas

Mantenimiento económico

DESVENTAJAS:

Si el hub falla la red no tiene comunicación si el nodo central falla toda la red se desconecta

Topologia de red.

Es similar a la topología de estrella, salvo que no tiene nodos centrales.

VENTAJAS:

Cableado punto a punto

DESVENTAJAS:

Si el segmento principal falla toda la red se viene abajo

Topologia de malla.

En la que cada nodo esta conectado a todos los nodos de esta manera es posible llevar los mensajes de un nodo a otro por diferentes caminos.

VENTAJAS:

Ofrece una redundancia y fiabilidad superior

Son ruteables

DESVENTAJAS:

Es de baja eficiencia de las conexiones y enlaces debido a la existencia de enlaces redundantes

Entopología híbrida o topología mixta.

las redes pueden utilizar diversas topologías para conectarse, la topología mixta es una de las más frecuentes y se deriva de la unión de varios tipos de topologías de red, de aquí el nombre de “mixtas” o “hibridas”.

Protocolos de una RED.

El Protocolo de red o también protocolo de Comunicación es el conjunto de reglas que especifican el intercambio de Datos u órdenes durante la Comunicación entre las entidades que forman parte de una red.

Estándares de redes

• IEEE 802.3, estándar para Ethernet

• IEEE 802.5, estándar para Token Ring

• IEEE 802.11, estándar para Wi-Fi

• IEEE 802.15, estándar para Bluetooth

Tipos de protocolos.

FTP: Protocolo de Transferencia de Archivos. Proporciona una Interfaz y servicios para la transferencia de archivos en la red.

SMTP: Protocolo Simple de Transferencia de Correo.Proporciona servicios de correo electrónico en las redes Internet e IP.

TCP: Protocolo de Control de Transporte. Es un protocolo de transporte orientado a la conexión.

TCP: gestiona la conexión entre las computadoras emisora y receptora de forma parecida al desarrollo de las llamadas telefónicas.

UDP: Protocolo de Datagrama de Usuario.Es un protocolo de transporte sin conexión que proporciona servicios en colaboración con TCP.

IP: Protocolo de Internet.Es la base para todo el direccionamiento que se produce en las redes TCP/IP y proporciona un protocolo orientado a la capa de red sin conexión.

ARP: Protocolo de Resolución de Direcciones. Hace corresponder las direcciones IP con las Direcciones MAC de hardware.

SAP: Protocolo de Anuncio de Servicio. Lo utilizan los servidores de archivo y los servidores de impresora de NetWare para anunciar la dirección del servidor.

NCP: Protocolo de Núcleo NetWare. Gestiona las funciones de red en las capas de aplicación, presentación y sesión. Gestiona además la creación de paquetes y se encarga de proporcionar servicios de conexión entre los clientes y servidores.

SPX: Protocolo de Intercambio Secuenciado de Paquetes. Es un protocolo de transporte orientado a la conexión.

IPX: Protocolo de Intercambio de Paquetes entre Redes. Es un protocolo de transporte sin conexión que gestiona el direccionamiento y encaminamiento de los datos en la red.

AppleShare: Proporciona servicios en la capa de aplicación.

AFP: Protocolo de Archivo AppleTalk. Proporciona y gestiona la compartición de archivos entre nodos de una red.

ATP: Protocolo de Transacción AppleTalk. Proporciona la conexión de capa de transporte entre Computadoras.

NBP: Protocolo de Enlace de Nombre. Hace corresponder los nombres de servidores de red con las direcciones de la capa de red.

ZIP: Protocolo de Información de Zona. Controla las zonas AppleTalk y hace corresponder los nombres de zonas con las direcciones de red.

AARP: Protocolo de Resolución de Direcciones AppleTalk. Hace corresponder las direcciones de la capa de red con las direcciones del hardware de enlace de datos.

DPP: Protocolo de Entrega de Datagramas. Proporciona el sistema de direccionamiento para la red AppleTalk, así como el transporte sin conexión de los datagramas entre las distintas computadoras.

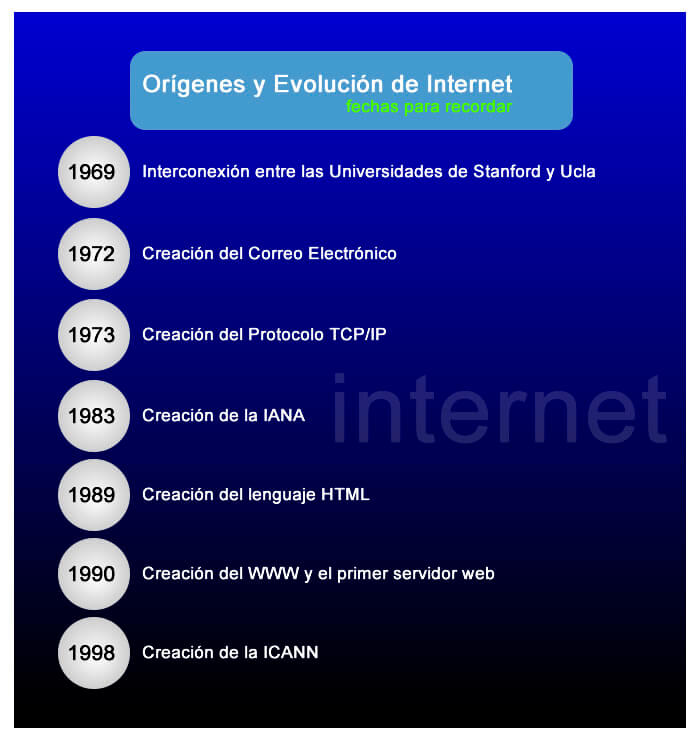

Orígenes de Internet.

La primera descripción registrada de las interacciones sociales que se podían habilitar a través de la red fue una serie de memorandos escritos por J.C.R. Licklider, del MIT, en agosto de 1962, en los que describe su concepto de “Red galáctica”. Imaginó un conjunto de ordenadores interconectados globalmente, a través de los que todo el mundo podría acceder rápidamente a datos y programas desde cualquier sitio. En espíritu, el concepto era muy similar a la Internet de hoy en día. Licklider era el director del programa de investigación informática de DARPA,4 que comenzó en octubre de 1962. Mientras estaba en DARPA convenció a sus sucesores en dicha agencia (Ivan Sutherland, Bob Taylor y Lawrence G. Roberts, investigador del MIT), de la importancia de su concepto de red.

Leonard Kleinrock, del MIT, publicó el primer documento sobre la teoría de conmutación de paquetes en julio de 1961 y el primer libro sobre el tema en 1964 Kleinrock convenció a Roberts de la factibilidad teorética de comunicarse usando paquetes en vez de circuitos, lo que fue un gran paso en el viaje hacia las redes informáticas. El otro paso clave fue conseguir que los ordenadores hablasen entre sí. Para explorar esta idea, en 1965, trabajando con Thomas Merrill, Roberts conectó el ordenador TX-2, en Massachusetts, con el Q-32, en California, mediante una línea telefónica conmutada de baja velocidad, creando la primera (aunque pequeña) red de área amplia del mundo. El resultado de este experimento fue la constatación de que los ordenadores con tiempo compartido podían trabajar bien juntos, ejecutando programas y recuperando datos según fuese necesario en el equipo remoto, pero que el sistema telefónico de conmutación de circuitos era totalmente inadecuado para esa tarea. Se confirmó la convicción de Kleinrock de la necesidad de la conmutación de paquetes. A finales de 1966, Roberts entró en DARPA para desarrollar el concepto de redes informáticas y rápidamente creó su plan para “ARPANET“, que publicó en 1967. En la conferencia en la que presentó el artículo había otra ponencia sobre el concepto de redes de paquetes, que venía del Reino Unido, de la mano de Donald Davies y Roger Scantlebury, del NPL. Scantlebury le comentó a Roberts el trabajo del NPL y el de Paul Baran y otras personas de RAND. El grupo RAND había escrito un artículo sobre redes de conmutación de paquetes para cifrar comunicaciones de voz en el ejército en 1964. La labor del MIT (1961-1967), de RAND (1962-1965) y del NPL (1964-1967) se había llevado a cabo en paralelo sin que los investigadores conociesen el trabajo de los demás. Se adoptó el término “paquete” del trabajo del NPL, y la velocidad de línea propuesta en el diseño de ARPANET pasó de 2,4 kbps a 50 kbps.

En agosto de 1968, después de que Roberts y la comunidad financiada por DARPA redefinieran la estructura general y las especificaciones de ARPANET, DARPA publicó una solicitud de presupuesto para desarrollar uno de los componentes clave, los conmutadores de paquetes llamados procesadores de mensajes de interfaz (IMP). La solicitud de presupuesto la ganó en diciembre de 1968 un grupo liderado por Frank Heart, de Bolt, Beranek y Newman (BBN). Mientras el equipo de BNN trabajaba en los IMP con Bob Kahn desempeñando un importante papel en el diseño arquitectónico general de ARPANET, Roberts, junto con Howard Frank y su equipo de Network Analysis Corporation, diseñaron la topología y la economía de la red. El sistema de medición de la red lo preparó el equipo de Kleinrock en UCLA. 6

Debido al temprano desarrollo de Kleinrock de la teoría de conmutación de paquetes y a su trabajo en el análisis, el diseño y la medición, su Network Measurement Center de UCLA fue seleccionado como el primer nodo de ARPANET. Se recogió el fruto de estos esfuerzos en septiembre de 1969, cuando BBN instaló el primer IMP en UCLA y se conectó el primer host. El proyecto de Doug Engelbart, “Augmentation of Human Intellect” (aumento del intelecto humano, que incluía NLS, un antecedente del sistema de hipertexto), en el Standford Research Institute (SRI), fue el segundo nodo. El SRI estaba detrás del Network Information Center, liderado por Elizabeth (Jake) Feinler, que incluía funciones como mantenimiento de tablas de nombres de host para asignar direcciones, así como de un directorio de RFC.

Un mes más tarde, cuando el SRI se conectó a ARPANET, se envió el primer mensaje de host a host desde el laboratorio de Kleinrock hasta el SRI. Se añadieron dos nodos más, en la Universidad de California en Santa Bárbara y en la Universidad de Utah. Estos dos últimos nodos incorporaron proyectos de visualización de aplicaciones, con Glen Culler y Burton Fried, de la Universidad de California en Santa Bárbara, investigando métodos para mostrar funciones matemáticas usando pantallas de almacenamiento para resolver el problema de la actualización en la red, y Robert Taylor e Ivan Sutherland, de Utah, investigando métodos de representación 3D en la red. De esta manera, a finales de 1969, había cuatro hosts conectados en la ARPANET inicial, e Internet iniciaba su trayectoria. Incluso en esta primera etapa, conviene destacar que la investigación sobre redes incorporaba trabajo sobre la red subyacente y trabajo sobre cómo usar la red. Esta tradición continúa hoy en día.

En los siguientes años, se añadieron rápidamente ordenadores a ARPANET, y se siguió trabajando para conseguir un protocolo de host a host funcionalmente completo y otro software de red. En diciembre de 1970, el Network Working Group (NWG), bajo el liderazgo de S. Crocker, terminó el protocolo de host a host inicial de ARPANET, llamado Network Control Protocol (NCP). Cuando los sitios de ARPANET terminaron de implementar NCP, en el periodo de 1971 a 1972, los usuarios de la red pudieron, por fin, comenzar a desarrollar aplicaciones.

En octubre de 1972, Kahn organizó una gran demostración de ARPANET, que tuvo mucho éxito, en la International Computer Communication Conference (ICCC). Fue la primera demostración pública de esta nueva tecnología de redes. En 1972 también se introdujo la aplicación “hot” inicial, el correo electrónico. En marzo, Ray Tomlinson, de BBN, escribió el software básico de envío y lectura de mensajes de correo electrónico, motivado por la necesidad de los desarrolladores de ARPANET de un mecanismo sencillo de coordinación. En julio, Roberts amplió su utilidad escribiendo la primera utilidad de correo electrónico para hacer listas de mensajes, leerlos selectivamente, archivarlos, reenviarlos y responder a los mismos. A partir de ese momento, el correo electrónico se convirtió en la aplicación de red más importante durante más de una década. Esto presagió el tipo de actividad que vemos hoy en día en la World Wide Web, es decir, un crecimiento enorme de todo tipo de tráfico “de persona a persona”.

Los primeros conceptos de Internet.

La ARPANET original se convirtió en Internet. Internet se basó en la idea de que habría múltiples redes independientes con un diseño bastante arbitrario, empezando por ARPANET como red pionera de conmutación de paquetes, pero que pronto incluiría redes de paquetes satélite, redes terrestres de radiopaquetes y otras redes. Internet tal y como la conocemos hoy en día plasma una idea técnica subyacente fundamental, que es la de red de arquitectura abierta. En este enfoque, la selección de una tecnología de redes no la dictaba una arquitectura particular de redes, sino que la podía elegir libremente un proveedor y hacerla trabajar con las demás redes a través de una “metaarquitectura de interredes”. Hasta ese momento solo había un método general para federar redes. Era el método tradicional de conmutación de circuitos, en el que las redes se interconectaban a nivel de circuito, pasando bits individuales de forma síncrona a través de una parte de un circuito completo entre un par de ubicaciones finales. Recordemos que Kleinrock había demostrado en 1961 que la conmutación de paquetes era un método de conmutación más eficiente. Además de la conmutación de paquetes, las interconexiones entre redes con fines especiales eran otra posibilidad. Aunque había otras maneras limitadas de interconectar redes diferentes, era necesario usar una como componente de la otra, y la primera no actuaba como par de la segunda ofreciendo servicios de extremo a extremo.

En una red de arquitectura abierta, las redes individuales se pueden diseñar y desarrollar por separado, cada una con su propia interfaz única, que puede ofrecerse a usuarios y otros proveedores, incluyendo otros proveedores de Internet. Se puede diseñar cada red según el entorno específico y los requisitos de los usuarios de esa red. En general, no existen restricciones sobre el tipo de redes que se pueden incluir o sobre su alcance geográfico, aunque ciertas consideraciones pragmáticas dictaminan lo que tiene sentido ofrecer.

La idea de las redes de arquitectura abierta la introdujo por primera vez Kahn, poco después de llegar a DARPA, en 1972. Su labor era originalmente parte del programa de radiopaquetes, pero posteriormente se convirtió en un programa independiente por derecho propio. En aquel momento, el programa se llamó “Internetting”. La clave para que el sistema de radiopaquetes funcionase era un protocolo de extremo a extremo fiable que pudiera mantener una comunicación efectiva frente a bloqueos y otras interferencias de radio, o soportar cortes intermitentes como los causados cuando se entra en un túnel o el terreno bloquea la señal. Kahn, al principio, se planteó desarrollar un protocolo solo para la red de radiopaquetes, ya que así evitaría tratar con una multitud de diferentes sistemas operativos, y seguir usando NCP.

Sin embargo, NCP no tenía la capacidad de dirigirse a redes (ni a máquinas) que estuvieran más allá de un IMP de destino de ARPANET, de modo que también hacía falta algún cambio en NCP. (Se asumía que ARPANET no se podía cambiar en este sentido). NCP dependía de ARPANET para ofrecer fiabilidad de extremo a extremo. Si se perdía algún paquete, el protocolo (y probablemente las aplicaciones a las que este daba soporte) se pararía de repente. En este modelo, NCP no tenía control de errores de host de extremo a extremo, ya que ARPANET sería la única red, y tan fiable que no haría falta un control de errores por parte de los hosts. Así pues, Kahn decidió desarrollar una nueva versión del protocolo que podría cubrir las necesidades de un entorno de redes de arquitectura abierta. Este protocolo se llamaría más adelante Protocolo de Control de Transmisión/Protocolo de Internet (TCP/IP). Mientras que NCP tendía a actuar como un controlador de dispositivo, el nuevo protocolo se parecería más a un protocolo de comunicaciones.

Cuatro reglas básicas fueron fundamentales en la primera concepción de Kahn:

- Cada red diferente debería mantenerse por sí misma, y no debía ser necesario cambio interno alguno para que esas redes se conectasen a Internet.

- La comunicación se haría en base al mejor esfuerzo. Si un paquete no llegaba a su destino final, se retransmitía poco después desde el origen.

- Se usarían cajas negras para conectar las redes; más adelante, estas cajas negras se llamarían puertas de enlace y enrutadores. Las puertas de enlace no guardarían información acerca de los flujos individuales de paquetes que pasaban por las mismas, manteniendo su sencillez y evitando la complicación de la adaptación y la recuperación a partir de varios modos de error.

- No habría control global a nivel operativo.

Otros problemas clave que había que resolver eran:

Algoritmos para evitar que los paquetes perdidos impidiesen permanentemente las comunicaciones y permitir que dichos paquetes se retransmitiesen correctamente desde el origen.

Ofrecer “segmentación” de host a host para que se pudiesen enviar múltiples paquetes desde el origen hasta el destino, según el criterio de los hosts, si las redes intermedias lo permitían.

Funciones de puerta de enlace para poder reenviar paquetes de manera adecuada. Esto incluía interpretar encabezados IP para enrutar, manejar interfaces, dividir paquetes en partes más pequeñas si era necesario, etc.

La necesidad de sumas de verificación de extremo a extremo, reensamblaje de paquetes a partir de fragmentos y detección de duplicados.

La necesidad de un abordaje global

Técnicas para el control del flujo de host a host.

Interfaces con los diferentes sistemas operativos

Había además otras preocupaciones, como la eficacia en la implementación y el rendimiento de las redes, pero estas, en principio, eran consideraciones secundarias.

Kahn comenzó a trabajar en un conjunto orientado a las comunicaciones de principios para sistemas operativos en BBN y documentó algunas de sus ideas iniciales en un memorándum interno de BBN titulado “Principios de comunicación para sistemas operativos“. En este momento, se dio cuenta de que sería necesario conocer los detalles de implementación de cada sistema operativo para tener la oportunidad de integrar cualquier protocolo nuevo de una forma eficaz. Así pues, en la primavera de 1973, tras comenzar el trabajo de lo que sería Internet, pidió a Vint Cerf (que entonces estaba en Stanford) que colaborase con él en el diseño detallado del protocolo. Cerf había estado involucrado de lleno en el diseño y desarrollo original de NCP, y ya tenía conocimiento sobre las interfaces de los sistemas operativos existentes. Así que, armados con el enfoque arquitectónico de Kahn para la parte de comunicaciones y con la experiencia de Cerf en NCP, se unieron para crear lo que se convertiría en TCP/IP.

Su colaboración fue muy productiva, y la primera versión escrita7 del enfoque resultante se distribuyó en una reunión especial del International Network Working Group (INWG), que se había creado en una conferencia de la Universidad de Sussex en septiembre de 1973. Se había invitado a Cerf a presidir ese grupo, y aprovechó la ocasión para celebrar una reunión con los miembros del INWG que eran numerosos en la Conferencia de Sussex.

Emergieron algunos enfoques básicos de esta colaboración entre Kahn y Cerf:

La comunicación entre dos procesos consistiría lógicamente en una secuencia larguísima de bytes (los llamaron octetos). Se usaría la posición de un octeto en la secuencia para identificarlo.

El control de flujo se haría usando ventanas deslizantes y confirmaciones (acks). El destino podría decidir cuándo confirmar, y cada ack devuelta se acumularía para todos los paquetes recibidos hasta ese momento.

No se concretó la manera exacta en la que el origen y el destino acordarían los parámetros de división de particiones que se usaría. Al principio se usaban los valores predeterminados.

Aunque en ese momento se estaba desarrollando Ethernet en Xerox PARC, la proliferación de LAN no se imaginaba entonces, y mucho menos la de los ordenadores personales y las estaciones de trabajo. El modelo original era de redes nacionales como ARPANET, y se esperaba que existiese un pequeño número de las mismas. Así pues, se usó una dirección IP de 32 bits, en la que los primeros 8 bits indicaban la red y los 24 bits restantes designaban el host de esa red. Fue evidente que habría que reconsiderar esta suposición, la de que sería suficiente con 256 redes en el futuro inmediato, cuando empezaron a aparecer las LAN a finales de los años 70.

El artículo original de Cerf y Kahn sobre Internet describía un protocolo, llamado TCP, que ofrecía todos los servicios de transporte y reenvío de Internet. La intención de Kahn era que el protocolo TCP soportase una serie de servicios de transporte, desde la entrega secuenciada totalmente fiable de datos (modelo de circuito virtual) hasta un servicio de datagrama, en el que la aplicación hacía un uso directo del servicio de red subyacente, lo que podía implicar la pérdida, la corrupción y la reordenación de paquetes. Sin embargo, el primer intento de implementar TCP produjo una versión que solo permitía circuitos virtuales. Este modelo funcionó bien para aplicaciones de inicio de sesión remoto y transferencia de archivos, pero algunos de los primeros trabajos en aplicaciones de red avanzadas, en particular la voz por paquetes de los años 70, dejaron claro que en algunos casos la pérdida de paquetes no podía ser corregida por TCP, y la aplicación debería encargarse de ella. Esto llevó a reorganizar el TCP original en dos protocolos, el IP simple, que solo dirigía y reenviaba paquetes individuales, y el TCP por separado, que se ocupaba de funciones del servicio como el control de flujos y la recuperación de paquetes perdidos. Para las aplicaciones que no querían los servicios de TCP, se añadió una alternativa llamada Protocolo de datagramas de usuario (UDP) para ofrecer acceso directo a los servicios básicos de IP.

Una de las principales motivaciones iniciales de ARPANET e Internet era compartir recursos, por ejemplo, permitir a los usuarios de las redes de radiopaquetes acceder a sistemas de tiempo compartido conectados a ARPANET. Conectar ambos era mucho más económico que duplicar estos ordenadores tan caros. Sin embargo, aunque la transferencia de archivos y el inicio de sesión remoto (Telnet) eran aplicaciones muy importantes, el correo electrónico ha sido, probablemente, la innovación de aquella época con mayor impacto. El correo electrónico ofreció un nuevo modelo de comunicación entre las personas, y cambió la naturaleza de la colaboración, primero en la creación de la propia Internet (como se comenta a continuación) y después para gran parte de la sociedad.

Se propusieron otras aplicaciones en los primeros tiempos de Internet, incluyendo la comunicación de voz basada en paquetes (el precursor de la telefonía por Internet), varios modelos para compartir archivos y discos y los primeros programas “gusano” que mostraron el concepto de agentes (y, por supuesto, virus). Un concepto clave de Internet es que no se había diseñado solo para una aplicación, sino como una infraestructura general en la que se podían concebir nuevas aplicaciones, como se ilustró más adelante con la aparición de la World Wide Web. Es la naturaleza generalista del servicio que ofrecen TCP e IP la que lo hace posible.

Evolución de la web 1.0 a la web 5.0

Servicios que ofrece el Interneth

El correo electrónico o e-mail: (Electronic mail) Es el servicio más utilizado y más común en la red. Si antes debíamos esperar días para recibir una carta del extranjero, hoy nos basta con unos minutos o incluso segundos. Este servicio permite enviar textos y archivos de imagen o sonido de forma muy fácil y sencilla, transmitiendo mensajes rápidos entre personas o grupos alrededor de todo el mundo en un tiempo récord.A diferencia de la dirección de nuestra casa, que está asignada y no podemos cambiar, las direcciones de correo electrónico las elegimos nosotros, al menos el nombre. Para obtener una dirección de e-mail tenemos varias opciones:

– Los ISP: Cuando un ISP o una empresa determinada te da acceso a Internet, lo normal es que te regalen una o más direcciones de correo, que puedes compartir con tu familia. Por ejemplo: Entel Internet, Telefónica, Manquehue Net, VTR, FirstCom, entre otros.

Las direcciones de e-mail se componen de tres partes:

– la primera es el nombre que tú eliges

– la segunda es el signo arroba (@)

– por último, el dominio de quien provee la casilla de correo.

Las principales ventajas de este tipo de servicio, comparado con el teléfono o el correo tradicional, son:

– Más velocidad (un mensaje puede llegar a cualquier punto del mundo en horas, minutos o incluso segundos).

– Más económico.

– Se pueden consultar bases de datos, bibliotecas, archivos, etc.

– Se pueden transferir ficheros y programas. El destinatario puede responder cuando le interesa. Incluso, si no quiere leerlo, lo borra y no lo abre.

Los MP3: Un MP3 es un sistema de compresión de audio con el que podemos almacenar música con la misma calidad de un CD, pero en mucho menos espacio.

Esto nos permite bajar a nuestro computador todo tipo de archivos de sonido o música; es decir, si quieres tener en tu computador la canción de tu grupo favorito, no tienes más que entrar a algunos de los sitios que ofrecen este servicio, escoger lo que te interesa y bajarlo a tu computador. Así, podrás escuchar las canciones cuantas veces quieras.

La videoconferencia: La videoconferencia es un sistema de comunicación especialmente diseñado para los encuentros a distancia, permitiéndonos ver, escuchar y hablar con personas de cualquier parte del mundo en tiempo real. Además, se puede compartir información de todo tipo, desde documentos hasta imágenes, fotografías y videos.

El comercio electrónico Después de todo lo que hemos mencionado, difícilmente el comercio y cualquier cosa que permita un ingreso extra podría quedar atrás. Por lo mismo, se creó el ya conocido comercio electrónico, que permite realizar todo tipo de transacciones y compras a través de Internet.

La ventaja principal de este servicio es que las tiendas virtuales no tienen horario, por lo que podemos comprar lo que queramos en cualquier parte del mundo, a cualquier hora y sin movernos de nuestro hogar. Porque, además, se paga con tarjetas de crédito y el despacho es a domicilio

Bajar programas: En la red existen diversos lugares de los cuales podemos obtener los programas más actuales que se están utilizando y bajarlos directamente a nuestro computador.

De todo lo que puedes conseguir en lo relativo a software, existen dos tipos: shareware y freeware.

Servicios de noticias: Una de las temáticas más buscadas en Internet son las noticias, ya que mantienen a todos los usuarios muy bien informados de la actualidad nacional e internacional.

Existen diversos medios de comunicación en Internet que, además de entregar las noticias a cada minuto, tienen envío diario vía e-mail para sus suscriptores. La mayor parte de los países del mundo tiene webs de sus medios de comunicación, lo que significa una gran cantidad de información noticiosa para los usuarios.

Educación: Los niños de nuestro país y del mundo merecen tener espacios donde encontrar todo tipo de información para realizar sus tareas y trabajos. Por lo mismo, en la red existen diversos sitios para aquellos que aún estén estudiando. La mayoría de los sitios se preocupan de entregar una información clara y precisa para que los más pequeños entiendan y puedan realizar sus tareas de manera fácil y entretenida.

Deportes: Los sitios de deporte son de los más visitados en Internet, ya que consta de millones de adeptos a lo largo de Chile y el mundo. Desde clases hasta resultados de campeonatos y noticias encontrarás en las millones de páginas deportivas que existen en toda la red.

Para los niños: Una de las máximas atracciones para los pequeños de la casa son los innumerables juegos que Internet ofrece. Lo bueno es que no es necesario bajarlos a tu computador para jugar; puedes hacerlo en línea y competir con otro jugador que se encuentre conectado igual que tú. Miles son las personas que juegan a diario, y tal vez en este momento sean millones.

Seguridad informatica: La Seguridad Informática se encarga de proteger la infraestructura computacional, los recursos electrónicos y la información considerados susceptibles de robo, pérdida o daño durante su desplazamiento en las redes; de manera personal, grupal u organizacional. Asimismo, la Seguridad Informática contiene los lineamientos y tecnología para garantizar que los recursos web, dentro de las Organizaciones, estén disponibles para cumplir sus funciones. Es decir, que no sean alterados por circunstancias o factores externos.

La Seguridad Informática, con el respaldo de Autoridades de Confianza o Certificación y tecnología avanzada como Secure Sockets Layes (SSL), utiliza: estándares, protocolos, métodos, reglas, herramientas y leyes concebidas para minimizar los posibles riesgos en el manejo de la infraestructura computacional e información contenida para los clientes o visitantes en el medio electrónico.

De esta forma, la Seguridad Informática protege los activos informáticos, entre los que se encuentran: 1) Información, 2) Infraestructura y 3) Usuarios web.

En primer lugar, la Seguridad Informática cubre la información privilegiada o confidencial que comprende software, bases de datos, metadatos, archivos y todo lo que para las Organizaciones es vulnerable, sensible o significa un riesgo si llega a manos de personas no autorizadas (crackers, defacers, scripts kiddies, script boys, viruxer, piratas informáticos o hackers) que buscan acceso a la redes para modificar, sustraer o borrar datos. En segunda instancia, protege la infraestructura computacional ante siniestros y riesgos, por ejemplo, de ataques de virus (residentes, de acción directa, de sobreescritura, de boot o arranque, de macro, de enlace o directorio, cifrados, polimórficos, multipartites, de fichero, de FAT, etcétera), códigos maliciosos, gusanos, caballos de troya y otras vulnerabilidades de los sistemas operativos o aplicaciones destinadas a dañar los recursos informáticos. Finalmente, cuida a los usuarios en las estructuras tecnológicas, zonas de comunicaciones y durante sus gestiones de información. En este sentido, establece normas que minimizan los riesgos a los que se exponen descargando contenidos de sitios web, en sus visitas a los portales o realizando transacciones en ellos.

consejos para mantener la seguridad informática:

1- Cuidado con los adjuntos en tu correo

2- Actualiza el software de tu sistema periódicamente

3- Crea mejores contraseñas y cámbialas cada seis meses

4- Usa antivirus y aplicaciones anti-malware

5- Acostumbra a cerrar las sesiones al terminar

6- Evita operaciones privadas en redes abiertas y públicas

7- Activa el Firewall de tu sistema

8- Evita software con recurrentes asociaciones a afecciones

9- Desconéctate de internet cuando no la necesites

10- Realiza copias de seguridad

Los virus.

Un virus informático es: Un programa, dañino, autoreproductor, y subrepticio. En primer lugar, está extremadamente claro que los virus son programas, realizados por personas, con el fin ineludible de causar daño en cualquiera de sus formas, aunque más no sea consumiendo memoria o espacio en disco y "molestando" al usuario. Una secuencia de instrucciones y rutinas creadas con el único objetivo de alterar el correcto funcionamiento del sistema y, en la inmensa mayoría de los casos, corromper o destruir parte o la totalidad de los datos almacenados en el disco.

tipos de virus informáticos:

Adware: Un adware es un software que muestra anuncios, señala Prado. “Los adware se instalan generalmente sin que nosotros lo deseemos. Por su parte, el CEO Roberto Payán, agrega que los adware suelen rastrear nuestro uso del ordenador para mostrar publicidad que tiene que ver con nuestras búsquedas en diferentes buscadores o relacionados con los sitios que visitamos.

Spyware: El spyware se trata de un software espía que recopila información de un ordenador. Tras obtener los datos, los transmite a una entidad externa sin el conocimiento o el consentimiento del propietario del ordenador.

Malware: Los expertos señalan que se trata de códigos diseñados por ciberdelincuentes que tienen por objeto alterar el normal funcionamiento del ordenador, sin el permiso o el conocimiento del usuario. Este tipo de virus puede destruir archivos del disco duro o corromper los archivos que se tienen albergados con datos inválidos.

Ransomware: Consiste en que un pirata bloquee el Smartphone o una PC con un mensaje en el que solicita un rescate para liberarlo. El usuario debe pagar dicho rescate si quiere recuperar la información.

Gusanos: Tiene la capacidad para multiplicarse en el sistema, por lo que tu ordenador podría enviar cientos o miles de copias de sí mismo, creando un efecto devastador a gran escala, adivierte Payán.

Troyano: Se trata de un tipo de programa que, al ejecutarlo, le brinda a un atacante acceso remoto al equipo infectado.

Denegación de servicio: Consiste en un ataque a un sistema de ordenadores o de red que causa que un servicio o recurso sea inaccesible a los usuarios legítimos.

Phishing: El representante de Innovatech refiere que se trata de una modalidad de ataque a través de un email. “Los hackers son capaces de adaptarse a la persona y/o al negocio para convencer de hacer clic en links o para ingresar datos confidenciales que terminarán por instalar un código malicioso en el ordenador”, asegura Prado.

Antivirus informáticos: Constituyen una herramienta básica de la seguridad informática, que garantiza en principios la protección final de una estación de trabajo contra la infección por programas malignos.

¿Quiénes crean los virus?

Los creadores de virus son los denominados hackers o crackers. La

mayoría buscan la notoriedad y el reconocimiento social.

Tienen como objetivo poner al descubierto agujeros de seguridad o

vulnerabilidades encontrados en conocidas herramientas informáticas.

También les impulsa el hecho de superarse a sí mismos desarrollando

nuevas tecnologías, nuevas técnicas de ingeniería social para engañar al

usuario, etc.

La deep web:

Conocida tambien como el Internet Invisible, engloba toda la información que se encuentra en la Web, pero que no se haya indexada por los motores de búsqueda tal y como los conocemos. Se trata, por tanto, de todo el contenido público online que no es rastreado ni encontrado por el usuario en la red.

Características.

Posee entre 400 y 500 veces más información que la Web normal

Entorno al 95% de la web profunda es de información accesible al público, es decir, no hay que pagar nada por ella.

Hay más de 200 mil millones de sitios web asociados a la Deep Web

La relación contenido-calidad es de alrededor de un 1000% respectod de la web superficial.

Las páginas funcionan bajo software que protege su identidad, como puede ser TOR.

Si decides entrar, ten claras algunas cosas con relativa facilidad, encontrarás anuncios sobre vídeos de sexo explícito, mutilaciones, violaciones, asesinatos, venta de órganos, drogas, armamento, sicarios, tarjetas de crédito, documentación de identidad falsa, manuales sobre cómo construir armas y explosivos, asesinar sin dejar rastro, blanquear dinero o trata de seres humanos. También se ofrecen servicios para la contratación de robos a la carta, alquiler de hackers, obtención de contraseñas y webs con contenidos racistas y xenófobos pero, sobre todo y en su mayoría, pornografía infantil.

El simple acceso y visionado de estos contenidos de momento en España no es delito, pero en otros países podría serlo. No sabes quién, como tú y también de forma "anónima", puede estar controlando o vigilando esos accesos y desde dónde.

No creas que todo lo que vas a ver es real. Hay muchas páginas, información, vídeos e imágenes trucadas, que sólo buscan captar tu atención mediante la provocación y el morbo. Si demandas otro tipo de servicios -mejor no saber- y buscas adquirir o contratar algo ilegal, has de tener presente que no sabes quién está detrás. Podría ser un estafador quien te vende un producto falso, manipulado o peligroso para tu salud, un vendedor a quien, por supuesto, no vas a poder reclamar absolutamente nada.

En la Web oculta también navega la Policía de cualquier país, y comprueba qué y quién está vendiendo y accediendo a esos servicios. Aunque, inicialmente la dirección de tu dispositivo electrónico puede ir cifrada y dice ser "anónima", en España y fuera de aquí se han producido detenciones de personas que ofrecían y contrataban esos servicios ilegales, así como la de administradores del mercado de compra-venta de estos servicio ilícitos Silk Road (el camino de la Seda), que llegó a mover cientos de millones de dólares.

No obstante, el acceso anónimo a la Deep web también tiene sus ventajas, sobre todo por esa privacidad, aunque no tan garantizada, para poder publicar y compartir archivos lícitos y de contenido sensible y que a veces sirve para burlar la censura de regímenes dictatoriales o Estados con sistemas políticos rígidos.

Si decides acceder para buscar contenidos lícitos, como un manual de hacking, por ejemplo, ojo con seguir los consejos que hay por ahí, sobre todo el de no acceder a esta Red desde tus propios dispositivos. Si utilizas conexiones ajenas, estarás dejando al descubierto a tu vecino y puede que, sin saberlo, lo que te descargues no sea un manual de hackers sino contenidos con pornografía infantil.

No obstante, valora el tener instalado un buen antivirus y firewall, no aceptes ni permitas la instalación de complementos y scripts, tapa la webcam, no introduzcas claves ni contraseñas si te lo piden, ni participes en ciertos foros.

REFERENCIAS.

https://sites.google.com/site/redes1118pc/home/redes-por-alcance/red-de-area-de-campus-can

https://www.lasexta.com/tecnologia-tecnoxplora/internet/ciudad-con-ley/que-riesgos-corres-decides-navegar-internet-profunda_2015011957f78f640cf2a2e945b3d07e.html

https://www.abc.es/tecnologia/redes/20150708/abci-deepweb-secretos-internet-oculta-201507072005.html

https://www.internautas.org/html/9806.html

https://www.semana.com/opinion/expertos/articulo/la-verdadera-deep-web/324575

https://www.ecured.cu/Antivirus_inform%C3%A1tico

https://tecnologia-informatica.com/que-es-un-antivirus-como-funciona/

https://edu.gcfglobal.org/es/virus-informaticos-y-antivirus/que-son-los-antivirus/1/

https://www.elnuevodiario.com.ni/suplementos/tecnologia/427037-virus-informaticos-mas-comunes/

https://www.abc.es/20111118/tecnologia/abci-diez-consejos-seguridad-informatica-201111181236.html

https://www.taringa.net/posts/info/3703375/Todo-sobre-virus-informatico.html

https://sites.google.com/site/topologiasdered708/home/doble-anillo

http://belleza.ihealth.life/?t202id=6278&t202kw=ad6&t202ref=0018ea8353c6326d1d0fb6424dad3eab59

https://www.certsuperior.com/SeguridadInformatica.aspx

https://sites.google.com/site/redeswikispaces/internet/que-es-internet/servicios-que-ofrece-internet

https://previa.uclm.es/profesorado/ricardo/internet/index_archivos/inet_servicios.htm

https://saber.digital/servicios-ofrece-internet-la-actualidad/

http://brendaromerodiaz.blogspot.com/

https://www.internetsociety.org/es/internet/history-internet/brief-history-internet/

https://www.ecured.cu/Protocolos_de_red

http://emocion-p4.blogspot.com/2010/05/protocolo-de-redes-informaticas.html

https://definicion.de/protocolo-de-red/

http://www.pythondiario.com/2017/12/redes-de-computadoras-protocolos-y.html

http://redeselie.blogspot.com/2010/05/cableado-de-una-red-principales-tipos_8613.html

https://www.ecured.cu/Nodo

https://www.monografias.com/trabajos24/redes-computadoras/redes-computadoras.shtml

http://redeselie.blogspot.com/2010/05/elementos-de-una-red-servidor-es-el.html

https://www.ecured.cu/Redes_de_datos

https://sites.google.com/site/redesdecomputadorasheyla/objetivos-de-las-redes

https://es.ccm.net/contents/252-el-concepto-de-red

https://definicion.de/protocolo-de-red/

http://www.pythondiario.com/2017/12/redes-de-computadoras-protocolos-y.html

https://youtu.be/iENeKGMIGV8

No hay comentarios.:

Publicar un comentario